Rola AI i uczenia maszynowego w cyberbezpieczeństwie

Jaką rolę odgrywa sztuczna inteligencja w cyberbezpieczeństwie?

W świecie, gdzie cyberprzestępcy atakują co kilka sekund, standardowi analitycy nie są w stanie nadążyć. Odpowiedzią na to wyzwanie jest sztuczna inteligencja (AI), która coraz częściej wspomaga i wzbogaca rozwiązania bezpieczeństwa. Sztuczna inteligencja przetwarza ogromne ilości danych w czasie rzeczywistym, dzięki czemu identyfikuje anomalie i wzorce trudne do wykrycia dla człowieka. Systemy wykorzystujące AI zapewniają szybsze wykrywanie zagrożeń, proaktywne reagowanie na incydenty i znacząco zwiększają ogólną skuteczność ochrony.

AI automatyzuje również czasochłonne zadania, takie jak analiza logów systemowych czy weryfikacja tożsamości. To odciąża zespoły ds. bezpieczeństwa, które mogą skupić się na strategicznych decyzjach i rozwiązywaniu złożonych problemów. Już od początku XXI wieku sztuczna inteligencja wspiera ekspertów w walce z rosnącą liczbą cyberataków. Jej zastosowanie w bezpieczeństwie danych, chmury czy IoT sprawia, że cyfrowe zasoby są po prostu lepiej chronione. Kluczem do tej skuteczności jest zdolność do uczenia się.

Jak działają AI i uczenie maszynowe w wykrywaniu zagrożeń?

Sztuczna inteligencja i uczenie maszynowe (ML) działają jak doświadczony strażnik, który uczy się, jak wyglądają standardowe zachowania i wzroce w chronionym systemie, aby natychmiast wykryć każdą anomalię. Wyobraź sobie kasjera w banku, który zna Twoje nawyki tak dobrze, że od razu zauważy, gdy ktoś inny próbuje wypłacić pieniądze z Twojego konta – nawet jeśli poda poprawny PIN. Algorytmy ML, w tym głębokie uczenie, tworzą model bazowy normalnej aktywności w sieci. Z perspektywy kursów „Advanced Learning Algorithms”, które realizowałem na Stanford University, kluczowe jest tu zrozumienie, że model nie szuka „zła”, ale matematycznej „odmienności”. To subtelna różnica wśród standardowych zachowań i wzorców, którą algorytmy nadzorowane (supervised learning) potrafią wyłapać i sklasyfikować znacznie szybciej niż jakikolwiek zespół ludzki. Następnie monitorują ją w czasie rzeczywistym, by wykryć wszelkie odstępstwa. To pozwala im identyfikować nieznane złośliwe oprogramowanie i ukryte zagrożenia, na przykład ataki wewnętrzne.

Narzędzia bezpieczeństwa bazujące na uczeniu maszynowym klasyfikują zagrożenia i nadają im priorytety, dzięki czemu zespoły bezpieczeństwa mogą skupić się na najpoważniejszych incydentach. Systemy te są również adaptacyjne – na podstawie danych historycznych przewidują przyszłe ataki i automatycznie aktualizują reguły, co pozwala im blokować nowe zagrożenia, odciążając tym samym analityków i pozwalając im skupić się na bardziej złożonych zadaniach.

Jak AI wspiera analityków w wykrywaniu zaawansowanych zagrożeń?

Dzięki zdolności do łączenia informacji z dużych zbiorów danych (Big Data) pochodzących z wielu źródeł, sztuczna inteligencja ułatwia analitykom efektywne wykrywanie zaawansowanych zagrożeń. Systemy bezpieczeństwa wykorzystujące AI samodzielnie przetwarzają tysiące zdarzeń, nadając im kontekst i priorytet. Analitycy nie muszą już manualnie przeglądać każdego alertu. Otrzymują skonsolidowane informacje o najpoważniejszych incydentach, dzięki czemu zespoły IT pracują wydajniej.

Zaawansowana analiza behawioralna użytkowników (UEBA) odgrywa tu kluczową rolę. W przeciwieństwie do zwykłej analizy użytkowników, UEBA monitoruje także zachowanie serwerów, aplikacji i urządzeń sieciowych. Pozwala to wykryć nie tylko podejrzane logowania (np. z nietypowej lokalizacji), ale także anomalie sprzętowe, takie jak nagły wzrost ruchu na serwerze. Co kluczowe, algorytmy te potrafią dostrzec subtelne powiązania między tymi z pozoru niezależnymi zdarzeniami, których człowiek mógłby nie zauważyć lub zlekceważyć. Dzięki takiemu wsparciu firmy mogą szybciej reagować na incydenty, a specjaliści mogą skupić się na proaktywnym poszukiwaniu zagrożeń.

Jak AI umożliwia predykcyjne modelowanie zagrożeń?

Przewidywanie zagrożeń staje się możliwe dzięki tworzonym przez AI modelom predykcyjnym, opartym na analizie danych historycznych, globalnych trendów czy informacji z darknetu. Algorytmy uczenia maszynowego modelują zachowania cyberprzestępców, a na tej podstawie prognozują przyszłe ataki i ich cele. Kolejnym obszarem wsparcia jest analiza podatności. Skanuje kod źródłowy w poszukiwaniu luk, co pozwala organizacjom wyprzedzać działania atakujących i proaktywnie wzmacniać swoją obronę. Jednym z najpotężniejszych narzędzi w tym arsenale jest analiza zachowań samych użytkowników.

Jak AI wykorzystuje analizę behawioralną użytkowników i podmiotów (UEBA)?

Analiza behawioralna użytkowników i podmiotów (UEBA) wspierana przez AI tworzy szczegółowe profile normalnych zachowań. To klucz do wykrywania zagrożeń. Sztuczna inteligencja przetwarza ogromne zbiory danych (Big Data), aby ustalić linię bazową aktywności dla każdej osoby. Sprawdza m.in.:

- godziny logowania,

- lokalizacje,

- dostęp do danych,

- aktywność sieciową,

- wykorzystanie aplikacji.

Takie profilowanie pozwala systemowi odróżnić typowe działania od anomalii, które mogą sygnalizować ryzyko nieautoryzowanego dostępu.

System natychmiast oznacza każde odstępstwo od ustalonego wzorca jako potencjalne zagrożenie. Może to być logowanie z nietypowej lokalizacji lub próba dostępu do poufnych plików użytkownika, który nie potrzebuje do nich dostępu w codziennej pracy. UBA jest szczególnie skuteczna w identyfikacji zagrożeń wewnętrznych, na przykład kradzieży danych przez pracownika. To właśnie w tym obszarze AI staje się niezbędna – potrafi zauważyć, że uprawniony administrator wykonuje działania, które choć technicznie dozwolone, drastycznie odbiegają od jego standardowego profilu behawioralnego. Potrafi wykryć nietypowe zachowanie, nawet jeśli ktoś używa prawidłowych poświadczeń. W ten sposób AI wzmacnia zarządzanie tożsamością i dostępem, pozwalając na proaktywną weryfikację i ochronę zasobów.

W jaki sposób AI pomaga redukować liczbę fałszywych alarmów?

Sztuczna inteligencja (AI) ogranicza liczbę fałszywych alarmów poprzez zaawansowaną analizę danych i kontekstualizację zagrożeń. Kluczowe jest tu uczenie maszynowe (ML), którego algorytmy stale doskonalą się na podstawie nowych informacji, ucząc się odróżniać prawdziwe ataki od nieszkodliwych anomalii. Podczas gdy tradycyjne systemy generują wiele nieistotnych alertów, systemy wykorzystujące AI filtrują i priorytetyzują zdarzenia, co redukuje tzw. zmęczenie alertami u analityków.

Eksperci z Cloud Security Alliance szacują, że systemy oparte na ML mogą zmniejszyć liczbę fałszywych alarmów nawet o 80%, jednocześnie zwiększając dokładność detekcji o 25%. To pozwala zespołom ds. cyberbezpieczeństwa skupić uwagę na incydentach o najwyższym priorytecie, co skraca czas reakcji i podnosi ogólną skuteczność obrony.

Jakie są praktyczne zastosowania AI w narzędziach bezpieczeństwa?

Sztuczna inteligencja zrewolucjonizowała nowoczesne narzędzia bezpieczeństwa, zwiększając ich skuteczność w wykrywaniu zagrożeń i automatyzacji reakcji. Główne kategorie tych narzędzi to:

- zapory nowej generacji (NGFW),

- rozwiązania zabezpieczające punkty końcowe (EDR, NGAV),

- systemy ochrony chmury i IoT,

- platformy SIEM i XDR.

Zapory nowej generacji (NGFW) wykorzystują AI do analizy ruchu sieciowego w czasie rzeczywistym. Na podstawie danych o zagrożeniach dynamicznie dostosowują reguły i blokują nowe wektory ataków.

W bezpieczeństwie chmury AI koreluje dane z wielu źródeł, by identyfikować podatności. W obszarze IoT wykrywa anomalie na pojedynczych urządzeniach i analizuje podejrzane wzorce w całej sieci. Sztuczna inteligencja jest też ważnym składnikiem systemów wykrywania oszustw, gdzie przewiduje i blokuje nieautoryzowane transakcje.

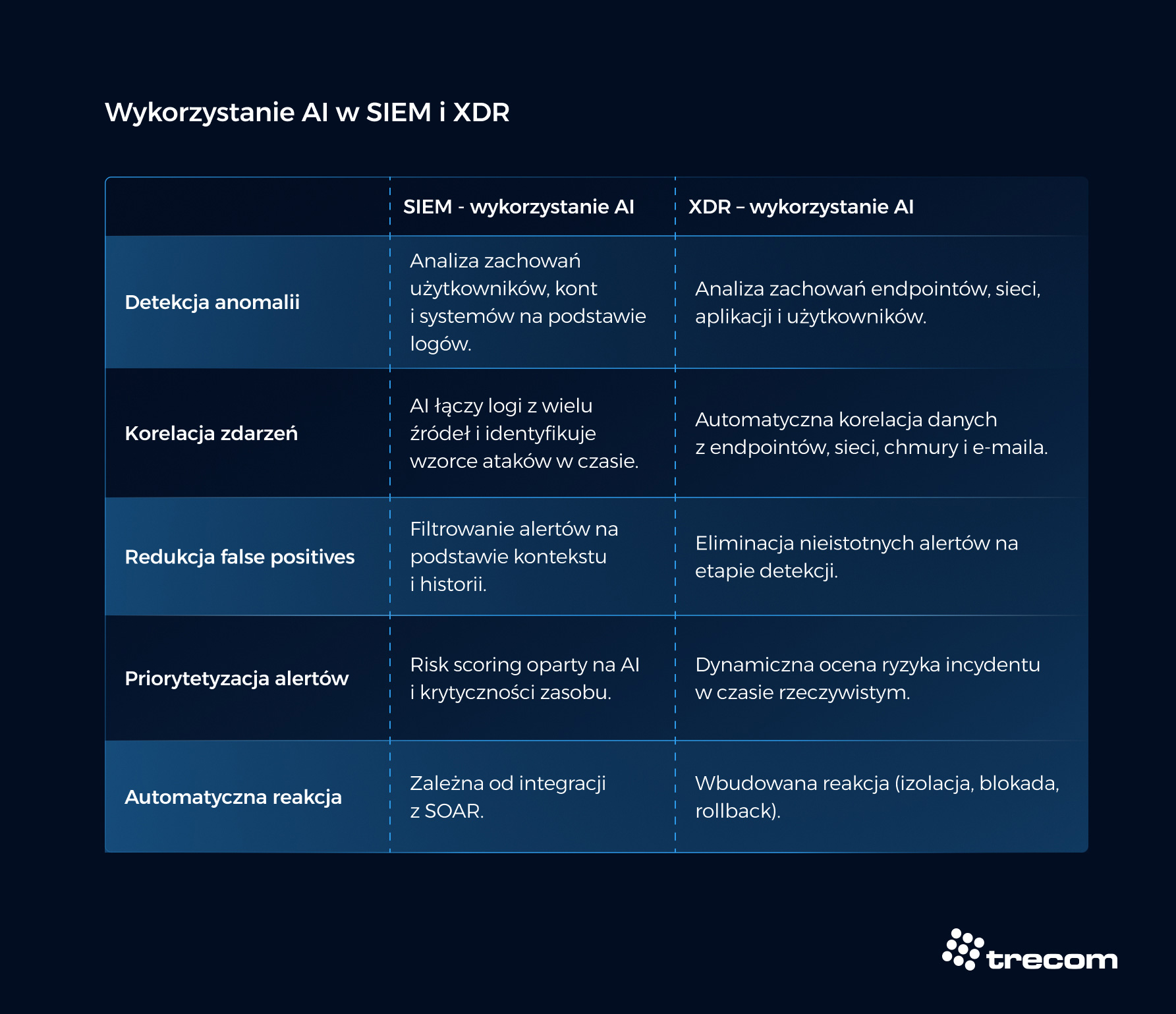

Jak AI usprawnia systemy SIEM i XDR?

W systemach SIEM (Security Information and Event Management) sztuczna inteligencja automatyzuje analizę i korelację danych. Przetwarza informacje z logów, ruchu sieciowego i punktów końcowych, aby identyfikować złożone incydenty. AI wspiera też utrzymanie SIEM, sugerując parsery dla nowych logów i pomagając w dostrajaniu reguł.

Platformy XDR (Extended Detection and Response) idą o krok dalej. AI łączy w nich dane z wielu źródeł, w tym z ochrony punktów końcowych, umożliwiając kompleksowe wykrywanie zagrożeń. W obu przypadkach algorytmy ML najpierw wykrywają anomalie, następnie nadają priorytet alertom i automatyzują kolejne zadania, co znacznie przyspiesza analizę i reakcję.

Jak AI wzmacnia ochronę punktów końcowych (EDR i NGAV)?

Systemy EDR i NGAV wykorzystują sztuczną inteligencję do wzmocnienia ochrony punktów końcowych, co zapewnia zaawansowane wykrywanie zagrożeń i automatyzację reakcji. Oparte na AI antywirusy nowej generacji (NGAV) używają uczenia maszynowego do blokowania nieznanego złośliwego oprogramowania. Na podstawie analizy behawioralnej zwalczają ataki bezplikowe i exploity. Systemy EDR z AI monitorują aktywność na urządzeniach, identyfikując luki i anomalie wskazujące na atak, np. ransomware.

Po wykryciu zagrożenia AI może automatycznie odizolować zainfekowany punkt końcowy, minimalizując szkody. Samodoskonalące się systemy antymalware stale aktualizują swoją wiedzę, co ułatwia zarządzanie podatnościami w całej organizacji.

Jak AI automatyzuje reagowanie na incydenty?

Sztuczna inteligencja wykorzystywana jest między innymi do automatyzacji reagowania na incydenty w rozwiązaniach klasy SOAR. Uruchamiają one z góry zdefiniowane sekwencje działań (playbooki) w odpowiedzi na zagrożenie. System może na przykład natychmiast odizolować zainfekowane urządzenie, odcinając je od sieci, aby zminimalizować szkody. Potem AI przeprowadza automatyczną remediację – przywraca systemy do bezpiecznego stanu lub aktualizuje reguły na firewallu. Dzięki automatyzacji analitycy mogą skupić się na strategicznych wyzwaniach, co podnosi efektywność zespołu IT.

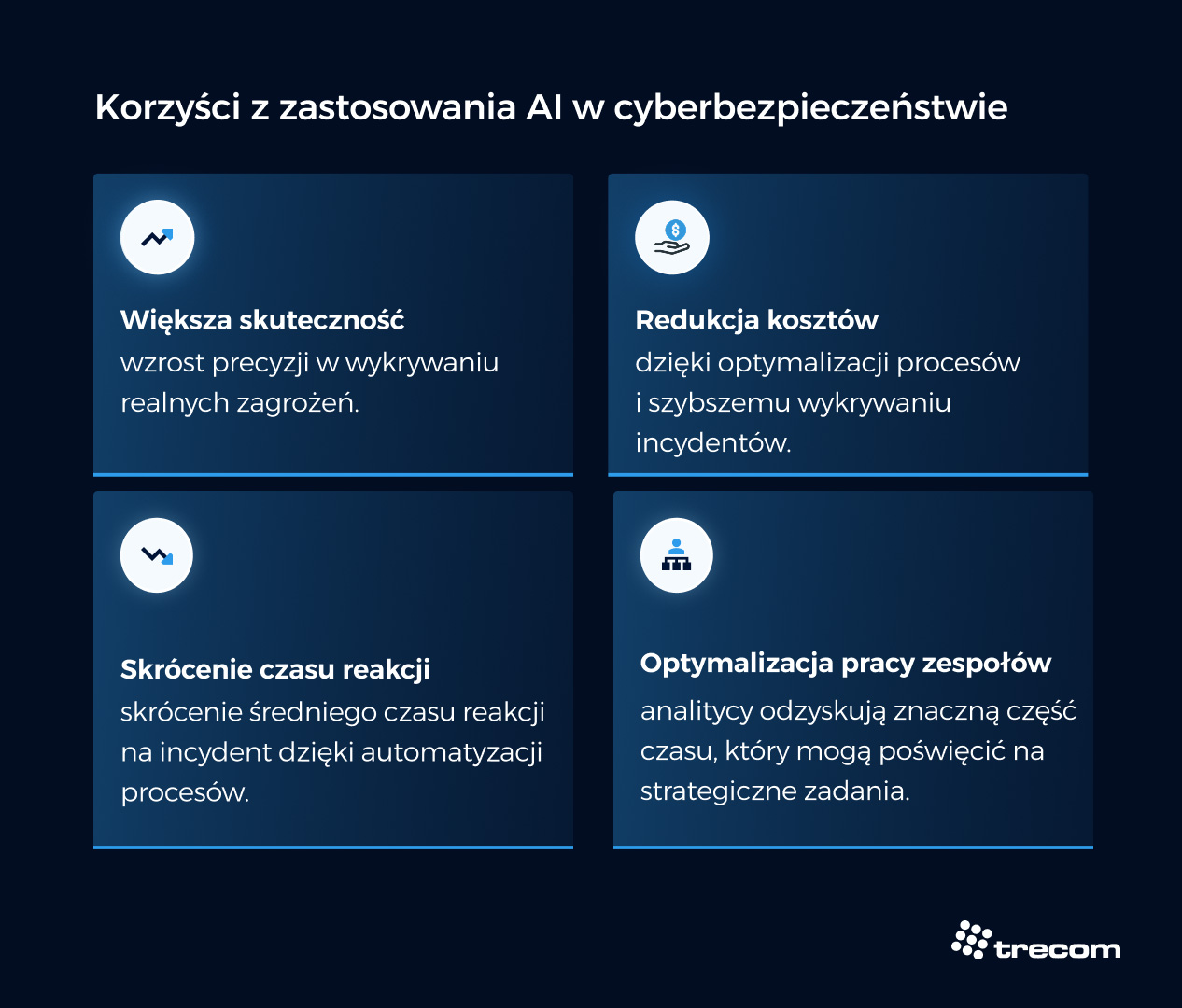

Jakie są korzyści ze stosowania AI w cyberbezpieczeństwie?

Stosowanie AI w cyberbezpieczeństwie przekłada się na konkretne korzyści operacyjne i finansowe, a organizacje stają się po prostu bezpieczniejsze. Główne zalety to:

- Większa skuteczność: Raporty branżowe wskazują na wzrost precyzji w wykrywaniu realnych zagrożeń. Organizacje korzystające z AI raportują 75% redukcję liczby naruszeń w porównaniu z tymi, które nie używają AI w cyberbezpieczeństwie.

- Skrócenie czasu reakcji: skrócenie średniego czasu reakcji na incydent dzięki automatyzacji procesów (np. playbooki w SOAR)

- Optymalizacja pracy zespołów: Analitycy odzyskują znaczną część czasu, który mogą poświęcić na strategiczne zadania. Argumentem za wdrożeniem AI nie jest już tylko „bezpieczeństwo”, ale twarda ekonomia i efektywność operacyjna. Klienci enterprise, z którymi pracuję, coraz częściej zauważają, że automatyzacja pierwszej linii obrony pozwala ich najdroższym ekspertom skupić się na realnych problemach, zamiast na manualnym przeglądaniu logów.

- Wymierne oszczędności: Unikanie kosztownych naruszeń i optymalizacja procesów przekładają się na oszczędności, zwłaszcza w dużych organizacjach.

AI poprawia widoczność w sieci i pozwala przewidywać zagrożenia. Wzmacnia także ochronę przed atakami wewnętrznymi, co buduje przewagę konkurencyjną i ułatwia zachowanie zgodności z regulacjami.

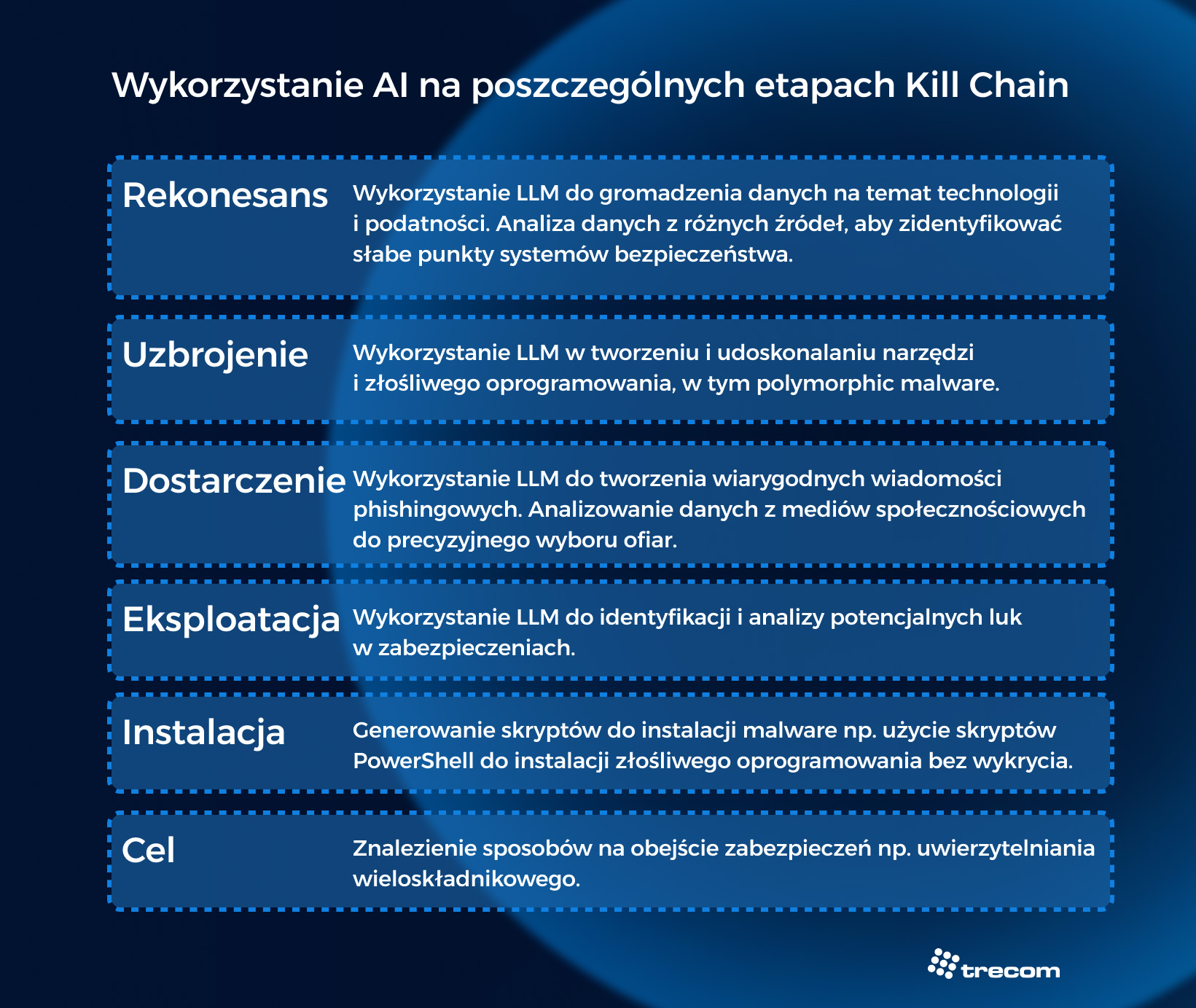

W jaki sposób cyberprzestępcy wykorzystują AI i ML do przeprowadzania ataków?

Cyberprzestępcy również wykorzystują sztuczną inteligencję. Zwiększają dzięki niej skalę, skuteczność i złożoność swoich ataków, co stanowi duże wyzwanie dla systemów obronnych. AI obniża barierę wejścia w świat cyberprzestępczości, pozwalając tworzyć złośliwe oprogramowanie bez głębokiej wiedzy technicznej. Cyberprzestępcy używają AI i ML na różne sposoby – na wszystkich etapach ataków.

Zastosowanie AI przez cyberprzestępców w ramach Kill Chain (framework autorstwa Lockheed Martin opisujący etapy cyberataku) może wyglądać następująco.

1. Faza rekonesansu: LLM-informed reconnaissance – wykorzystanie LLM do gromadzenia danych na temat technologii i potencjalnych luk w zabezpieczeniach. Analiza danych z różnych źródeł, aby zidentyfikować słabe punkty systemów bezpieczeństwa.

2.Faza uzbrojenia: LLM-aided development – Wykorzystanie LLM w tworzeniu i udoskonalaniu narzędzi i złośliwego oprogramowania. Ciekawym przykładem jest polymorphic malware – złośliwe oprogramowanie, które stale zmienia swój kod, aby uniknąć wykrycia przez zabezpieczenia bazujące na sygnaturach.

3. Faza dostarczenia: Phishing – Wykorzystanie generatywnej AI do tworzenia autentycznych wiadomości phishingowych – bez błędów ortograficznych i gramatycznych, z odpowiednim kontekstem kulturowym. Na tym etapie AI wykorzystywane jest również do analizowania danych z mediów społecznościowych do precyzyjnego wyboru ofiar.

4. Faza eksploatacji: LLM-assisted vulnerability research – wykorzystanie LLM do identyfikacji i analizy potencjalnych luk w zabezpieczeniach.

5. Faza instalacji: LLM-enhanced scripting techniques – generowanie skryptów do instalacji malware np. użycie skryptów PowerShell do instalacji złośliwego oprogramowania bez wykrycia.

6. Faza Celu: LLM-directed security feature bypass – Znalezienie sposobów na obejście zabezpieczeń np. uwierzytelniania wieloskładnikowego.

Szczególnymi przykładami ataków z wykorzystaniem AI jest prompt hacking (manipulowanie instrukcjami dla AI) czy prompt leaking (wymuszanie na modelu ujawnienia poufnych danych treningowych), wymierzone bezpośrednio w modele sztucznej inteligencji wykorzystywane w atakowanej organizacji.

Przykładami narzędzi bazujących na AI i ML wykorzystywanych przez cyberprzestępców są DarkBERT, TrojAI, FraudGPT czy Chaos GPT.

Jak generatywna AI jest używana do tworzenia deepfake’ów i phishingu?

Generatywna AI pozwala cyberprzestępcom tworzyć wysoce realistyczne deepfake’i – fałszywe nagrania audio i wideo tworzone dzięki technikom takim jak deep learning. Używają ich do manipulacji i oszustw, na przykład wirtualnych porwań z użyciem syntetyzowanego głosu. Sztuczna inteligencja generuje też spersonalizowane wiadomości phishingowe, które naśladują styl komunikacji zaufanych osób, co utrudnia weryfikację tożsamości i zwiększa skuteczność ataków. Poziom zaawansowania tych metod jest wysoki – nawet narzędzia AI wykrywają fałszywe treści z zaledwie 54% skutecznością.

Jakie są wyzwania i ryzyka związane z AI w cyberbezpieczeństwie?

Wdrożenie AI w cyberbezpieczeństwie niesie ze sobą nie tylko korzyści, ale i poważne ryzyka. Największym wyzwaniem technicznym pozostaje jakość danych. Sztuczna inteligencja wymaga ogromnych, czystych zbiorów do treningu. Ich niska jakość prowadzi do błędnych decyzji i fałszywych alarmów, co obciąża zespoły bezpieczeństwa. Organizacje muszą mierzyć się także z atakami na same algorytmy oraz z problemami etycznymi. Potencjalne nadużycia AI mogą prowadzić do naruszeń bezpieczeństwa, a także strat finansowych związanych ze skomplikowanym wdrożeniem.

Czym jest zatruwanie danych i kradzież modeli AI?

Atakujący mogą celowo manipulować zbiorami treningowymi, czyli „zatruwać dane” (data poisoning). W efekcie algorytmy AI zaczynają działać błędnie, a systemy bezpieczeństwa mogą ignorować prawdziwe zagrożenia. Innym zagrożeniem jest kradzież modeli AI, która polega na nieautoryzowanym skopiowaniu wytrenowanego algorytmu. Cyberprzestępcy mogą go wtedy analizować i wykorzystywać do obchodzenia zabezpieczeń. Aby chronić swoje modele, organizacje muszą dbać o jakość danych treningowych i stosować ścisłą kontrolę dostępu.

Jakie problemy etyczne i prawne wiążą się z użyciem AI?

Użycie AI w cyberbezpieczeństwie rodzi złożone problemy etyczne i prawne. Główne obawy dotyczą naruszenia prywatności. Systemy te wymagają dostępu do ogromnych ilości danych, co pozwala na zaawansowane profilowanie użytkowników i stanowi wyzwanie dla regulacji. Kwestia odpowiedzialności również budzi wątpliwości. Brak transparentności działania AI, znany jako problem „czarnej skrzynki”, utrudnia wskazanie winnego za błędy maszyn. Algorytmy mogą również powielać istniejące uprzedzenia, prowadząc do dyskryminacji. Z kolei automatyzacja zadań grozi negatywnym wpływem na rynek pracy.

Jaka jest przyszłość sztucznej inteligencji w walce z cyberzagrożeniami?

Przyszłość AI w cyberbezpieczeństwie zmierza w kierunku autonomicznych systemów bezpieczeństwa. Będą one samodzielnie podejmować decyzje i reagować na zagrożenia bez udziału człowieka. Coraz ważniejsza stanie się predykcja zagrożeń w czasie rzeczywistym, wspierana przez uczenie maszynowe i analizę behawioralną. Adaptacyjne systemy obronne, wykorzystujące deep learning i sieci neuronowe, będą uczyć się i dostosowywać do nowych taktyk atakujących.

Czeka nas również głębsza integracja z IoT, co zapewni kompleksową ochronę połączonych urządzeń. Rola człowieka ewoluuje w kierunku strategicznego nadzoru. Będzie to współpraca, w której AI uzupełnia umiejętności analityków. Rozwój ten stawia jednak nowe wyzwania. Wiąże się z tym potrzeba stworzenia solidnych regulacji prawnych oraz inwestycji w specjalistyczną edukację, która przygotuje ekspertów do pracy z zaawansowanymi technologiami, w tym z generatywną AI.

Źródła

- https://cybersecurityventures.com/cybersecurity-almanac-2024/

- https://cloudsecurityalliance.org/blog/2025/03/14/a-i-in-cybersecurity-revolutionizing-threat-detection-and-response

- https://www.ncbi.nlm.nih.gov/pmc/articles/PMC12508882/

- https://journalwjarr.com/sites/default/files/fulltext_pdf/WJARR-2025-4132.pdf

Michał Ciemiega – Head of Sales and Business Development z ponad 15-letnim doświadczeniem w IT i cyberbezpieczeństwie, specjalizujący się w budowie strategii sprzedaży, skalowaniu zespołów oraz wdrażaniu metodyk MEDDPICC i MEDDIC. Łączy ekspertyzę biznesową z zaawansowaną wiedzą z zakresu sztucznej inteligencji, analizy danych i uczenia maszynowego, prowadząc projekty rozwojowe i ekspansję rynkową na poziomie executive.

Paweł Guraj

02.03.2026

Aleksander Bronowski

04.02.2026

info@trecom.pl

info@trecom.pl +48 22 488 72 00

+48 22 488 72 00